大模型

本实验室致力于推动大模型在动态真实场景中的发展,研究重点涵盖持续学习(CL)、参数高效微调(PEFT)与强化微调(RFT)。我们聚焦以下核心方向:制定策略以缓解灾难性遗忘——即大语言模型在学习新任务时丢失既有知识的倾向;提升模型在自然语言理解、代码生成与数学推理等多领域的适应能力;并同时应对高算力成本、参数干扰及数据隐私风险等挑战。

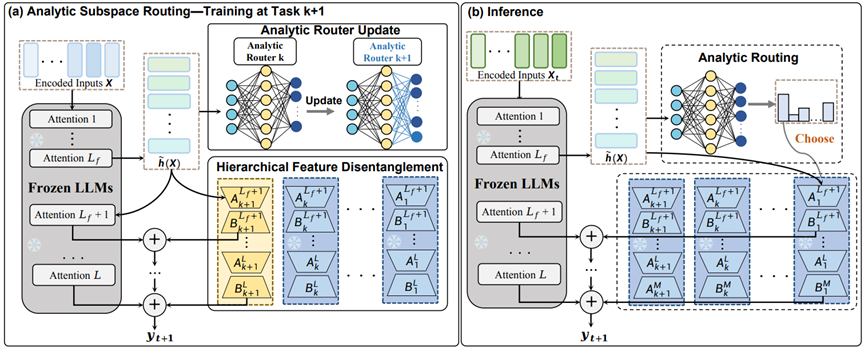

本文针对大语言模型持续学习中的灾难性遗忘问题,以及现有方法的局限——如回放机制带来的高成本、单一参数模块导致的任务干扰或容量不足——提出解析子空间路由(Analytical Subspace Routing, ASR)。ASR 在每个新任务到来时,于深层特征空间内为其构造独立的低秩适配器(LoRA),并通过基于递归最小二乘(RLS)训练的动态路由器,依据输入特征自动选择最适合的 LoRA 模块进行推理。该路由器可利用自相关与互相关矩阵在不依赖历史数据的情况下进行增量更新,从而在理论上实现零遗忘。